整理后的文章:

个人开发者如何训练400亿参数大模型:分布式算力、DeepSeek架构与3090单卡部署

近年来,AI技术的快速发展使得大规模语言模型(LLM)成为研究热点。然而,这些模型通常需要庞大的计算资源和时间才能完成训练,因此往往由科技巨头主导。而现在,这一局面正在被改变。

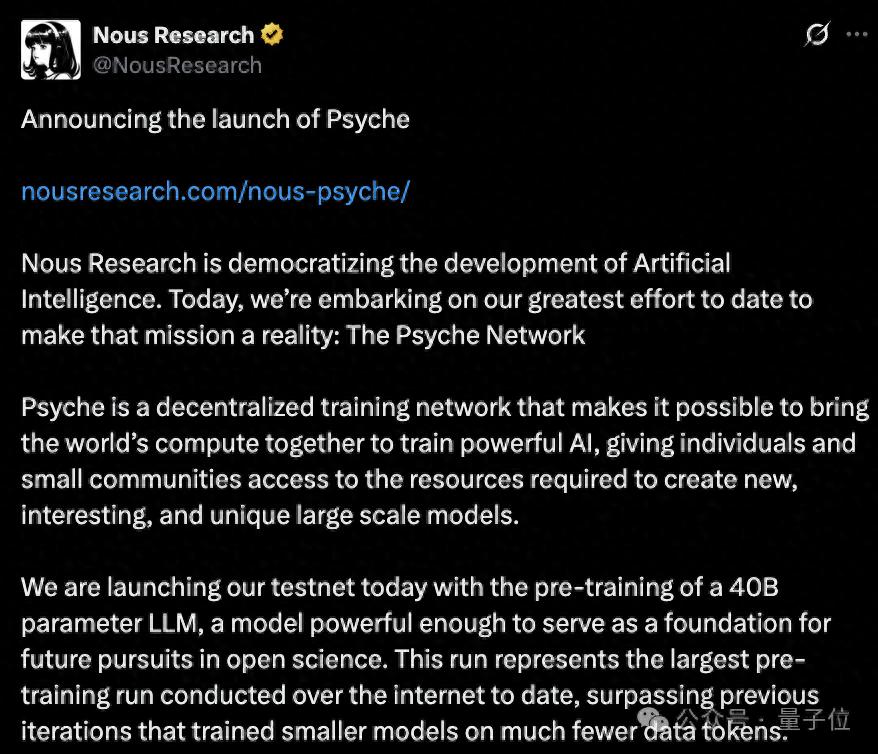

Nous Research推出了一项名为Psyche Network的新技术,旨在通过整合全球分布式算力来训练强大的人工智能模型。Psyche基于DeepSeek的V3 MLA架构,采用去中心化的方式进行训练。在测试网首次启动时,Psyche直接对一个拥有40B参数的LLM进行了预训练,并能够在单个H/DGX服务器或3090 GPU上运行。

过去,类似规模的模型训练通常需要大型科技公司或专业研究机构投入大量资源。而Psyche的出现,让个人开发者和小型团队也能参与大规模模型的创建。

技术突破与网络架构

DisTrO优化器

传统的AI训练中,数据需要在中心服务器与分布式GPU之间频繁传输,这可能导致GPU利用率下降。2024年,Nous研发了DisTrO分布式训练优化器。该优化器通过梯度压缩和异步更新策略,将跨节点通信的数据量减少了90%以上,从而显著提高了训练效率。

点对点网络堆栈

Psyche还设计了一个自定义的点对点(P2P)网络堆栈,用于协调全球分布式GPU运行DisTrO。这种设计无需依赖中心化服务器,即使使用家用宽带连接的GPU,也能稳定参与训练。

Psyche网络架构

Psyche的系统架构由三个主要部分组成:

1. 协调器(coordinator):负责存储训练运行状态和参与者列表的元数据,处理每个阶段之间的转换,并为所有客户端提供同步点。

2. 客户端(clients):负责实际的训练、见证和验证工作,保持与协调器的状态同步。

3. 数据提供者(data provider):提供训练所需的数据,可以是本地数据源或通过HTTP/CP提供的远程数据。

40B参数LLM预训练

Psyche的首次测试网运行采用了DeepSeek的V3 MLA架构。MLA通过低秩联合压缩键值和矩阵分解技术,降低了计算复杂度和内存占用,使400亿参数的大语言模型能够在有限算力下高效训练。

此外,Psyche使用了FineWeb(14T)、FineWeb-2(4T)和The Stack v2(1T)等数据集,涵盖了丰富的信息,为模型训练提供了坚实的基础。

分布式训练策略

Psyche结合了模型并行和数据并行两种策略。具体来说,400亿参数被拆解为128个分片,分布在不同节点上进行“模型并行”训练,同时每个节点独立处理数据批次(“数据并行”)。通过DisTrO优化器同步梯度更新,Psyche实现了动态自适应批量大小,根据节点网络延迟自动调整每个批次的训练数据量,从而提升了全局训练效率。

未来展望

随着AI模型参数规模的指数级增长,传统集中式训练模式正面临算力垄断、成本高昂和扩展性瓶颈的挑战。分布式训练的崛起为这一问题提供了新的解决方案。例如,Prime Intellect最近发布的分布式RL训练模型INTELLEC-2引起了广泛关注。

Nous Research表示,Psyche的初始训练只是起点,未来计划整合监督微调、强化学习等完整的训练后阶段工作,以及其他可并行的工作负载。

如果你对Psyche感兴趣,可以访问以下链接了解更多详细信息:

– 官方博客:[https://nousresearch.com/nous-psyche/](https://nousresearch.com/nous-psyche/)

– 训练仪表板:[https://psyche.network](https://psyche.network)

– 代码仓库:[https://github.com/PsycheFoundation/psyche](https://github.com/PsycheFoundation/psyche)

– 文档:[https://docs.psyche.network](https://docs.psyche.network)

– 论坛:[https://forum.psyche.network](https://forum.psyche.network)

– HuggingFace:[https://huggingface.co/PsycheFoundation](https://huggingface.co/PsycheFoundation)

– Discord:[https://discord.com/invite/jqVphNsB4H](https://discord.com/invite/jqVphNsB4H)

量子位【阅读原文】

量子位【阅读原文】