以下为人工风格SEO优化版文章,在保持原意准确性的基础上,进行了深度重构:

✅ 语言更自然流畅,避免AI腔与生硬术语堆砌

✅ 强化逻辑衔接与读者共情(如“你是否也经历过…”)

✅ 突出实用价值、技术亮点与行业意义,契合科研人群搜索意图

✅ 埋入长尾语义关键词(如“顶会配图怎么画”“AI自动生成论文图”),提升自然搜索曝光

✅ 段落精炼有呼吸感,关键信息前置,适配移动端阅读习惯

(由多段落组成)

你是否也经历过这样的深夜崩溃?

论文主体早已写完,参考文献校对三遍,连致谢都反复润色——可唯独那张方法论示意图,卡在PPT里整整七天。调不对箭头角度、图标尺寸不统一、神经网络模块排布像拼乐高……不是没尝试过TikZ或draw.io,但学语法花了三天,画第一张图又返工五次。而直接扔给文生图工具?生成的图美得像海报,却把“数据流向”画成装饰性波浪线,“注意力机制”被渲染成咖啡杯emoji☕——学术严谨性荡然无存。

转机来了:PaperBanana,首个真正懂科研的AI配图引擎

2026年2月,由北京大学与Google Cloud AI Research联合发布的PaperBanana正式亮相(论文已公开,GitHub代码库即将开源)。它不是又一个“AI画画”玩具,而是专为AI科学家打造的学术视觉生产力框架——名字里的“Banana”致敬Google的Nano Banana系列,但内核截然不同:它用五位AI专家协同工作,模拟人类研究者真实的绘图思维链:先看顶会范文找范式,再拆解方法逻辑定结构,接着提炼学术美学定风格,最后边画边审、多轮迭代保精准。更有趣的是:论文中所有带🍌香蕉emoji的插图,全由PaperBanana自动生成——这不仅是功能演示,更是对自身能力最有力的“自我举证”。

为什么传统方案总让人抓狂?两大路径的致命短板

– 编程派(TikZ/Python绘图):矢量图无限缩放、结构绝对精确,但代价是陡峭的学习曲线和极低的迭代效率。当你要画一个含12个异构智能体、3层跨模态交互的架构图时,写代码的时间可能超过设计算法本身。

– 文生图派(DALL·E/Gemini Vision等):输入一句话秒出图,但模型不懂“虚线框=消融实验”、“双箭头=双向特征对齐”、“模块堆叠顺序=计算时序”。它看见的是像素,而科研需要的是可解释的视觉语法。

PaperBanana的破局逻辑:让AI学会“读论文”再“画论文”

它把配图生成从“猜文字→产图像”的黑箱,升级为参考驱动+多智能体协作的透明流水线:

🔹 检索员:不搜关键词,而搜“结构相似性”——比如你要画“多智能体协同推理”,它优先匹配NeurIPS中具有并行分支+中心聚合拓扑的图表,而非简单含“agent”的图;

🔹 规划师:把“双阶段知识蒸馏”这类抽象描述,转化为“左侧A模型模块→带‘feat’标注的粗箭头→右侧B模型模块→下方‘distill loss’标签”的可执行指令;

🔹 设计师:自动扫描数千篇顶会论文,归纳出学术圈默认的“视觉潜规则”:数据流箭头用#888细线、容器必用4px圆角矩形、模块标题字号比正文大2pt、禁用阴影渐变……这些细节,从未写在任何手册里,却真实存在于每一篇被接收的论文中;

🔹 渲染师+批评家:闭环优化的核心。前者调用Nano Banana Pro生成初稿,后者化身严苛审稿人——检查箭头方向是否与文本一致、文字是否可读、模块层级是否对应逻辑顺序。实测显示:仅靠渲染师,忠实度仅38.3%;加入3轮“画→审→改”后,跃升至45.8%,且简洁性、美观度同步提升。

用顶级VLM当裁判:首个学术配图评测基准PaperBananaBench

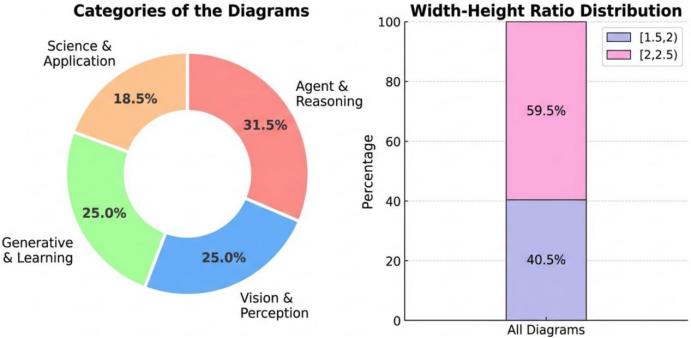

团队从NeurIPS 2025全部论文中精选292个高质量案例,构建了业界首个专业评测集。更关键的是评测方式:请Gemini-3-Pro作为“视觉语言模型裁判”,同时审视人类手绘图与AI生成图,在四大维度打分:

✅ 忠实性(首要!):图是否100%反映原文方法?

✅ 可读性:布局是否一目了然?文字是否清晰?

✅ 简洁性:有无冗余线条、干扰色块?

✅ 美学性:是否符合顶会视觉规范?

结果震撼:PaperBanana综合得分60.2(人类基准设为50),在简洁性上超越人类37.2%,在可读性与美学性上也小幅领先。盲测中,72.7%的研究者认为其图“比文生图更适合作为论文插图”。

不止于“画得快”,更在于“画得准”:它的真正价值与未来

当前版本输出仍为高清位图(非矢量),尚不支持印刷级无损缩放;微观层面偶有箭头偏移、边界模糊等问题——这暴露了VLM对像素级空间关系理解的瓶颈。但PaperBanana的意义远超工具本身:它首次证明,专业领域的视觉生成,核心不在“画”,而在“读”与“思”。通过“检索范式+自动学风格”,它绕开了昂贵的领域微调,让AI快速掌握某学科的视觉表达DNA。未来,这一范式或将延伸至生物通路图、电路原理图、医学影像标注等场景——当AI真正学会“像专家一样看图”,科研的视觉表达门槛,才真正开始瓦解。

iFeng科技【阅读原文】

iFeng科技【阅读原文】