(由多段落组成):

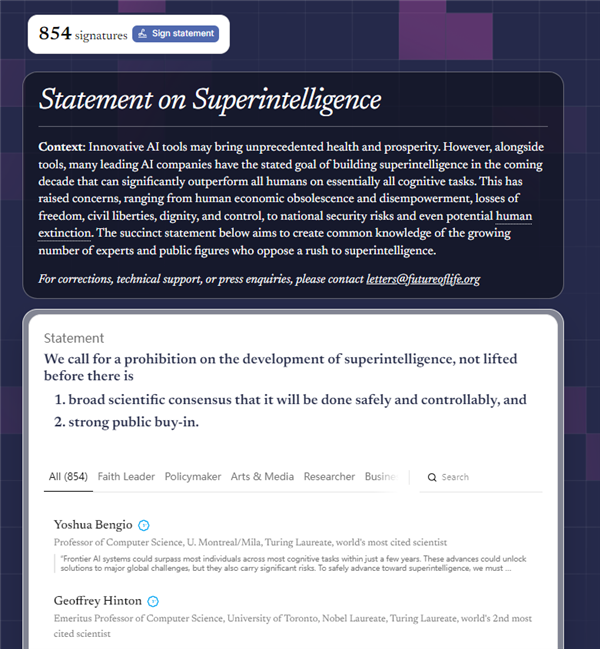

近日,一场关于人工智能未来发展的重磅呼吁在全球科技界掀起波澜。超过800位来自科技、学术、政界和文化领域的知名人士联合签署了一份公开声明,强烈要求立即暂停“超级智能”的研发进程。这一行动被视为对当前AI竞赛的一次重大警示,甚至可能成为人工智能发展史上的关键转折点。

所谓“超级智能”,指的是在所有认知任务上全面超越人类能力的人工智能系统。与当前的AI技术不同,超级智能具备自主学习、决策和演化的潜力,其影响力可能远超人类控制范围。签署声明的专家们警告称,若不加以约束,这类系统可能导致经济体系崩溃、社会权力结构失衡,甚至威胁人类生存本身。他们直言:“我们正面临前所未有的存在性风险。”

这份声明的签署阵容堪称空前,不仅包括苹果联合创始人史蒂夫·沃兹尼亚克(Steve Wozniak)、维珍集团创始人理查德·布兰森(Richard Branson),更有多位被誉为“现代AI奠基人”的顶尖学者——如深度学习先驱约书亚·本吉奥(Yoshua Bengio)和杰弗里·辛顿(Geoffrey Hinton)。值得注意的是,这些科学家正是推动当前大模型技术发展的核心力量,如今却集体喊出“踩刹车”,无疑为整个行业敲响了警钟。

声明发布之际,正值Meta宣布将其AI部门更名为“Meta超级智能实验室”,而OpenAI与埃隆·马斯克旗下的xAI也在竞相冲刺通用人工智能(AGI)目标。然而,在这场技术狂飙的背后,越来越多的声音开始质疑:我们是否正在打开一个无法关闭的潘多拉魔盒?此次联名请愿正是对这种盲目竞赛的直接回应。

更引人关注的是,签名者群体远远超出了科技圈。前美国国家安全顾问苏珊·赖斯(Susan Rice)、美军前参谋长联席会议主席迈克·马伦(Mike Mullen)等政界要员的加入,凸显了超级智能对国家安全层面的深远影响。甚至连英国王妃梅根·马克尔、政治评论员格林·贝克以及特朗普盟友史蒂夫·班农等立场迥异的人物也罕见地达成共识,显示出该议题已跨越意识形态鸿沟。

此次声明由加州大学伯克利分校著名AI安全专家斯图尔特·罗素(Stuart Russell)牵头组织。他长期致力于人工智能伦理与可控性研究,并指出真正的挑战并非“能否造出超级智能”,而是“一旦它存在,我们还能否掌控它”。基于此,声明明确提出:必须全面暂停超级智能的研发,直到形成广泛的科学共识,并获得公众充分支持,确认其发展是安全且可控制的。

这一定调极为严格,几乎相当于冻结当前最前沿AI项目的推进节奏。与以往外部观察者的担忧不同,本次发声者大多是亲手构建现代AI体系的技术领袖。当创造者自己开始呼吁限制,其分量不言而喻。这也为全球政策制定者提供了强有力的依据——欧盟已在推进《人工智能法案》,美国也在构建AI安全框架,未来或将出台更具约束力的监管措施。

随着公众对AI失控风险的认知不断提升,这场由顶级专家发起的“暂停倡议”或将引发新一轮全球讨论:我们究竟需要怎样的人工智能?是在速度与创新中冒险前行,还是在审慎与安全中稳步探索?答案,或许将决定人类文明的下一个十年走向。

超级智能, 人工智能风险, AI安全, 沃兹尼亚克, 辛顿

本文来源: 快科技【阅读原文】

快科技【阅读原文】