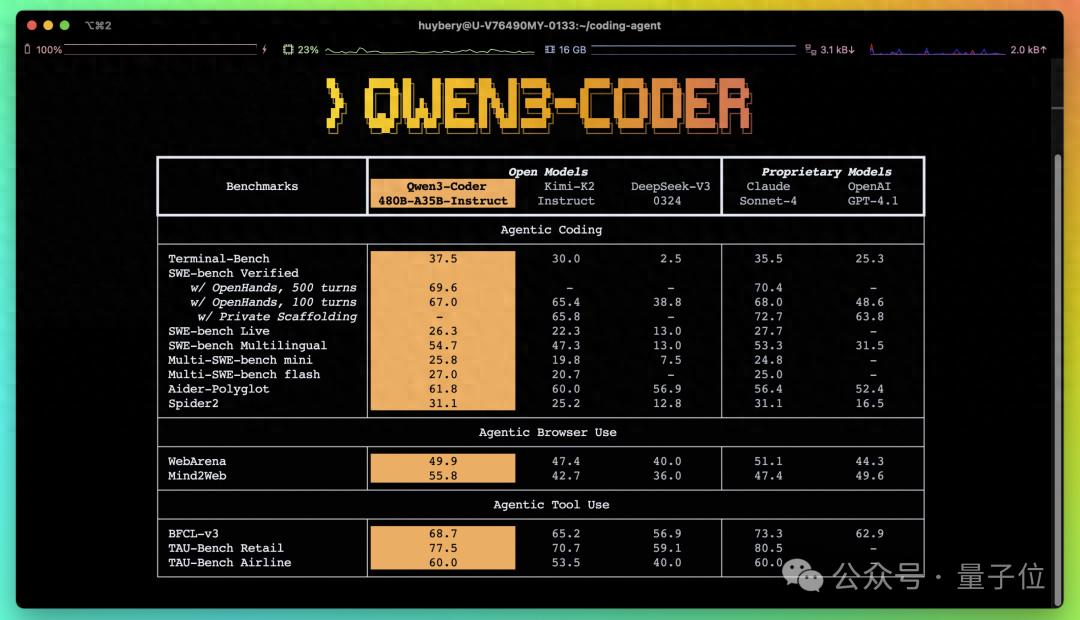

在AI编程领域,一场由国产模型引发的技术风暴正在席卷全球。阿里通义实验室最新推出的开源编程大模型 Qwen3-Coder,一经发布便引发广泛关注。它不仅在多项编程基准测试中超越了同类开源模型,甚至在某些指标上击败了闭源的行业标杆 Claude Sonnet 4,堪称开源编程模型的又一里程碑。

Qwen3-Coder 包含多个版本,其中最强版本为 Qwen3-Coder-480B-A35B-Instruct,采用 MoE 架构,激活参数达 35B,支持原生 256K 上下文长度,通过 YaRN 技术可进一步扩展至 1M 上下文,极大提升了模型在处理复杂代码任务时的能力。

编程效率飞跃:Qwen Code 命令行工具同步上线

除了模型本身,通义团队还推出了命令行工具 Qwen Code,基于 Gemini Code 适配了 prompt 与工具调用协议,并进行了二次开发与开源。这使得开发者可以在本地环境中高效调用模型,实现代码生成、调试与优化的全流程自动化,真正实现“即写即用”的编程体验。

一句话指令,生成复杂应用

Qwen3-Coder 的强大之处在于其对自然语言指令的理解能力。只需一句简单的提示词,即可生成高质量、可交互的代码。例如:

– “用 p5.js 创建一个多彩的可交互动画”

– “生成一个 3D 地球可视化页面”

– “做一个动态天气信息卡片”

– “写一个扫雷小游戏”

实测结果显示,Qwen3-Coder 能够准确理解指令并输出功能完整、结构清晰的代码,极大降低了编程门槛,提升了开发效率。

技术细节揭秘:从预训练到强化学习的全方位升级

在技术层面,Qwen3-Coder 的训练过程同样值得深入关注。其预训练数据总量高达 7.5T tokens,其中 70% 为代码数据,显著提升了模型在编程任务上的表现力。

此外,团队采用了 数据扩展、上下文扩展和合成数据扩展 等多种策略,进一步增强模型泛化能力。通过引入 Qwen2.5-Coder 对低质量数据进行清洗与重写,训练数据质量大幅提升。

在后训练阶段,Qwen 团队创新性地采用 Code RL(代码强化学习)和 Long-Horizon RL(长周期强化学习)策略,构建了可同时运行 20000 个独立环境 的系统,使模型在多轮交互中表现出色,尤其在 SWE-bench Verified 上实现了 开源模型的 SOTA(State-of-the-Art)表现。

开源优势凸显,开发者热情高涨

相比闭源模型如 Claude Code 需要每月付费使用,Qwen3-Coder 完全免费开源,采用 Apache License Version 2.0 协议,支持商业用途,真正实现了“技术自由”。

目前,开发者可以通过以下方式体验 Qwen3-Coder:

– 访问 Qwen 官网在线体验

– 安装 Qwen Code 命令行工具

– 在阿里云百炼平台申请 API 接口调用

开源社区对 Qwen3-Coder 的发布反响热烈,不少开发者表示这是开源编程 Agent 领域的一次重大飞跃。

未来已来:国产模型引领全球开源潮流

随着 Qwen3-Coder 的推出,国产大模型在开源领域的领先地位愈发明显。不仅在性能上实现突破,更在技术透明度和生态建设上展现出强大竞争力。

可以预见,未来开源编程模型将越来越成为开发者和企业的首选。而 Qwen3-Coder 的发布,无疑为这一趋势注入了新的动力。

本文来源: 量子位【阅读原文】

量子位【阅读原文】