(由多段落组成):

近年来,全球科技领域不断取得突破性进展。近日,韩国高级科学技术院(KAIST)与TB级互联与封装实验室(TERA)联合发布了对未来十年HBM高带宽内存及AI GPU加速卡发展的预测报告,其令人震撼。

目前,HBM技术的最先进版本为HBM3E,已被应用于NVIDIA B300系列和AMD MI350系列中,最大容量可达288GB。下一代HBM4即将问世,预计NVIDIA Rubin系列将支持最高384GB,而AMD MI400系列则有望冲击432GB大关。

随着技术的进一步发展,未来标准尚未完全确定,但据推测,HBM5的容量可能达到400-500GB,而HBM6或将实现1536-1920GB(即1.5-1.9TB)。更令人惊叹的是,HBM7的容量预计将高达5120-6144GB,也就是约4.2-6TB!

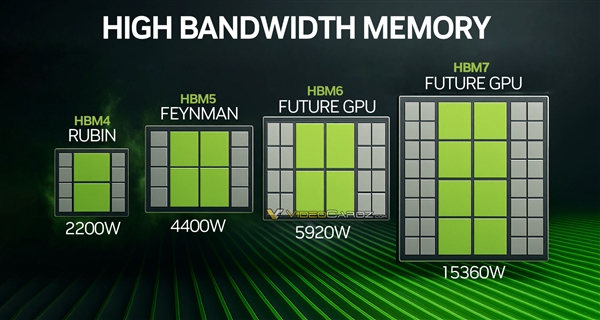

NVIDIA Rubin预计于明年发布,其芯片面积为728平方毫米,功耗达800W,并采用双芯整合封装设计。搭配8颗HBM4内存,数据带宽可高达32TB/s,整卡功耗预计将达到2200W。相比之下,当前的AMD MI350系列风冷版功耗为1000W,水冷版为1400W,而NVIDIA B300系列同样达到了1400W。

展望未来,NVIDIA计划在2029年推出代号为Feyman的新一代AI GPU。该产品预计核心面积约为750平方毫米,芯片功耗接近900W,采用四芯整合封装技术,中介层面积约为4800平方毫米,搭配8颗HBM5内存,带宽可达48TB/s,整卡功耗预计高达4400W。

然而,这仅仅是开始。根据纯理论推测,2032年推出的下一代GPU单芯片面积可能缩小至700平方毫米,但功耗将突破1000W。通过四芯整合封装技术,中介层面积将超过6000平方毫米,并配备多达16颗HBM6内存,带宽可达256TB/s,整卡功耗接近6000W。

再往后看,到2035年,新一代GPU单芯片面积将进一步缩小至600平方毫米,功耗却飙升至1200W。首次引入八芯片整合封装技术后,中介层面积将超过9000平方毫米,并搭载32颗HBM7内存,带宽达到惊人的1TB/s,整卡功耗更是高达15000W!如此庞大的功耗需求不禁让人担忧:未来的数据中心是否需要一座核电站来支撑?

本文来源: 快科技【阅读原文】

快科技【阅读原文】