(由多段落组成):

在人工智能飞速发展的2025年,一个真正具备“理解世界”能力的开源多模态大模型横空出世——来自北京智源人工智能研究院(BAAI)的 悟界·Emu3.5 正式发布,迅速成为全球AI社区关注的焦点。作为目前最先进的原生开源多模态世界模型基座,Emu3.5不仅在图像生成、视频建模和文本理解方面实现全面突破,更在动态物理世界的模拟上树立了全新标杆。

与传统AIGC模型仅停留在“生成画面”的层面不同,Emu3.5的核心目标是让AI真正“懂”这个世界。它不再只是被动响应指令,而是像智能体一样主动推理空间关系、时间逻辑与因果链条。例如,当用户要求“移走桌上的苹果”,模型能准确推断出桌面应随之变空;在第一人称视角漫游中,即便用户转身或移动,背后的场景依然保持一致,展现出前所未有的空间连贯性与物理真实性。

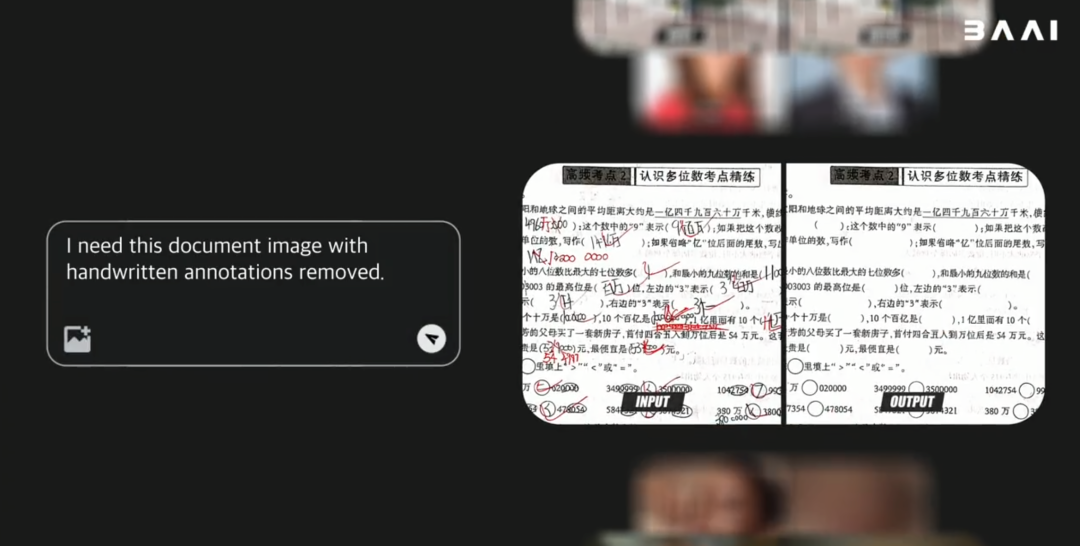

这一能力使得Emu3.5在多种复杂任务中表现惊艳。无论是构建可交互的3D虚拟环境,还是生成带步骤说明的教学图文,甚至是模拟火星卡丁车驾驶等超现实场景,都能做到细节丰富、逻辑自洽。更令人惊叹的是,一句简单指令即可清除手写痕迹,精准完成高阶图像编辑,展现出媲美专业设计师的操作水准。

在技术架构上,Emu3.5采用仅340亿参数的Decoder-only Transformer结构,却通过创新设计实现了远超其体量的性能表现。其核心在于将所有任务统一为“下一状态预测”(Next-State Prediction),无论是文字描述、图像变化还是动作演进,都被转化为序列化Token进行建模。这种统一范式极大提升了模型对长时序、跨模态任务的理解能力。

训练数据方面,Emu3.5依托超过10万亿Token的海量互联网视频与图文配对数据,深度学习真实世界的时空演变规律。配合基于IBQ框架打造的强大视觉分词器,拥有高达13万词汇量,并集成扩散解码器,支持2K分辨率图像的高质量重建,确保输出结果既清晰又富有细节。

为了进一步提升模型的实用性,团队还引入了多阶段对齐策略:在预训练基础上,经过大规模监督微调(SFT)和多模态强化学习(RL),结合美学评分、图文一致性、故事连贯性等多项指标优化,使模型在实际应用中更加稳定可靠。

值得一提的是,针对自回归生成速度慢的行业难题,智源研发了名为“离散扩散适配”(DiDA)的推理加速技术。该技术打破逐Token生成的传统模式,转而采用并行双向预测机制,在不牺牲生成质量的前提下,将图像推理效率提升近20倍,显著降低部署成本。

最令开发者振奋的消息是:Emu3.5全面开源! 这意味着全球研究者和企业无需从零起步,即可基于这一强大基座开发智能体、构建虚拟世界、升级AIGC工具链。无论是在教育、影视、游戏还是工业仿真领域,Emu3.5都打开了前所未有的想象空间。

目前,项目官网已开放技术报告、体验申请入口及完整资源链接,科研内测通道也已上线,欢迎广大AI爱好者与从业者共同探索这个“会思考的世界模型”。

世界模型, 多模态AI, Emu3.5, 开源大模型, 智能体

本文来源: 量子位【阅读原文】

量子位【阅读原文】