(由多段落组成)

AMD 在人工智能领域再下一城,最新推出的 MI350X 和 MI355X 两款 GPU 引发广泛关注。据官方介绍,这两款芯片在大模型推理性能上比英伟达的 B200 快了整整 30%,并得到了 OpenAI 创始人奥特曼的亲自站台支持。此次发布标志着 AMD 正式向英伟达发起挑战。

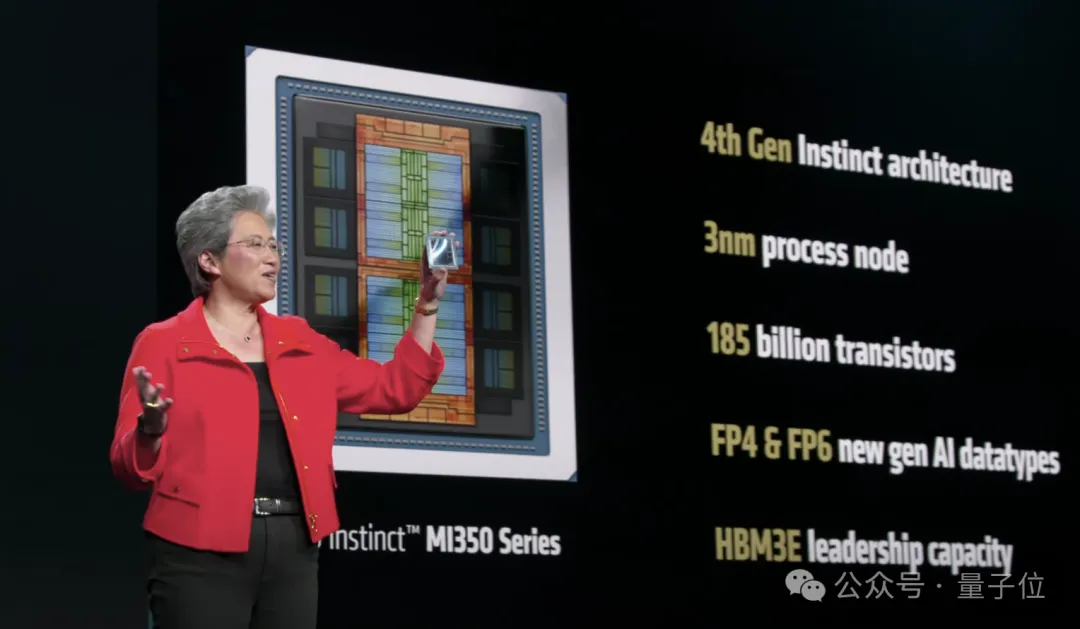

MI350 系列采用了先进的 3nm 工艺,包含高达 1850 亿个晶体管,并配备了最新的 HBM3E 内存技术。与前代产品 MI300X 相比,MI350 系列的算力提升了 4 倍,推理速度更是快了 35 倍。此外,其内存容量达到了英伟达 B200 的 1.6 倍,训练和推理速度也实现了相当甚至超越的表现。

具体来看,MI350X 和 MI355X 的核心设计相同,但散热方式有所区别:前者采用风冷设计,后者则使用液冷技术,类似于英伟达的 B200。基于第四代 Instinct 架构(CDNA 4),它们均配备了 288GB 的 HBM3E 内存和每秒 8TB 的内存带宽,远超英伟达同类产品。

在功耗方面,风冷版 MI350X 的最高 TBP 为 1000W,而液冷版 MI355X 则达到了 1400W。更高的功耗带来了更强的性能,MI355X 的表现明显优于同架构的 MI350X。在高精度计算(FP64)中,MI350X 和 MI355X 的算力分别为 72 和 78.6 TFLOPs,约为英伟达的两倍。

对于低精度格式(如 FP16、FP8 和 FP4),MI350 系列的性能与英伟达相当或略胜一筹。值得一提的是,MI350 系列支持 FP6 性能以 FP4 的速率运行,这一特性被认为是 AMD 的差异化优势。

为了进一步优化性能,AMD 还推出了全新的 ROCm 7 软件栈,相比前一代 ROCm 6 提升了 3.5 倍的推理性能和 3 倍的训练性能。同时,ROCm 7 深度集成了 VLM 和 SGLang 等开源推理框架,并支持超过 180 万个 Hugging Face 模型的开箱即用。

展望未来,AMD 计划于明年推出下一代 GPU——MI400 系列。这款芯片由 AMD 和 OpenAI 联合研发,预计性能将比 MI300 系列快 10 倍,FP4 运行速度可达 40 PFLOPs。MI400 系列还将配备高达 432GB 的 HBM4 内存和每秒 19.6TB 的内存带宽。

此外,AMD 还规划了到 2027 年的产品路线图,其中包括 MI500 系列 GPU 和 Verono CPU,目标是“突破性能、效率和可扩展性的极限”。无论是 AI 推理还是训练,AMD 的全新产品线都展现出了强大的竞争力。

本文来源: 量子位【阅读原文】

量子位【阅读原文】