近年来,随着人工智能技术的快速发展,机器学习模型在各个领域的应用越来越广泛,从推荐系统到自动驾驶都离不开它的支持。然而,这些系统的普及也带来了不容忽视的环境问题。据科技媒体报道,Meta AI 旗下的 FAIR 团队与佐治亚理工学院共同开发了一种名为 CATransformers 的框架,旨在通过优化模型架构和硬件性能,显著降低碳排放,为可持续发展的 AI 技术铺平道路。

AI 系统通常需要大量的计算资源来支持其运行,而这往往依赖于定制化的硬件加速器。无论是训练还是推理阶段,这些过程都会消耗大量能源,从而导致运营中的碳排放增加。此外,硬件从生产到报废的整个生命周期中还会产生所谓的“隐含碳”,进一步加重了对生态环境的影响。因此,如何减少 AI 技术在运营和制造过程中的双重碳排放,已经成为全球各行业亟待解决的重要问题。

目前,许多减排方法主要集中在提升运营效率上,例如优化训练和推理过程中的能耗,或者提高硬件的使用率。然而,这些方法往往忽略了硬件设计和制造阶段的碳排放,并且未能充分考虑模型设计与硬件效率之间的相互作用。针对这一问题,FAIR 团队与佐治亚理工学院合作推出的 CATransformers 框架,将碳排放作为核心设计指标之一。

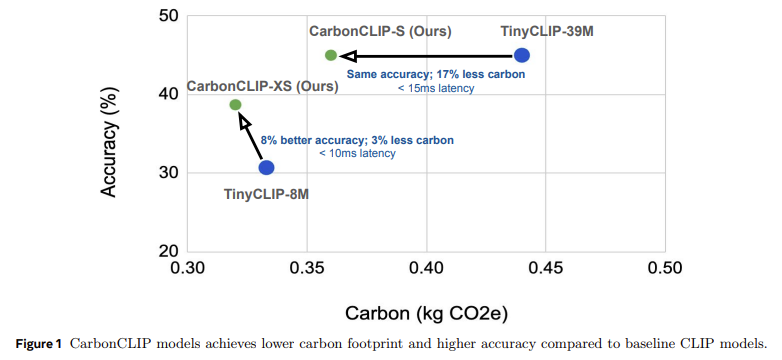

CATransformers 借助多目标贝叶斯优化引擎,同时评估模型架构和硬件加速器的性能,从而实现延迟、能耗、精度以及总碳足迹之间的平衡。特别是在边缘推理设备的应用场景中,该框架通过对大型 CLIP 模型进行剪枝生成变体,并结合硬件估算工具分析碳排放与性能表现。实验结果显示,CarbonCLIP-S 在保持与 TinyCLIP-39M 类似精度的同时,碳排放降低了 17%,延迟控制在 15 毫秒以内;而 CarbonCLIP-XS 则比 TinyCLIP-8M 提高了 8% 的精度,碳排放减少了 3%,延迟低于 10 毫秒。

研究表明,如果仅优化延迟而不考虑碳排放,可能会导致隐含碳增加高达 2.4 倍。相比之下,综合优化碳排放与延迟的设计策略可以削减 19-20% 的总排放量,同时几乎不影响延迟表现。CATransformers 的推出为可持续机器学习系统的开发提供了重要参考,表明在 AI 开发过程中结合硬件能力和碳影响考量,能够实现性能与环保的双赢局面。

随着 AI 技术规模的不断扩大,CATransformers 框架为行业提供了一条可行的减排路径,帮助构建更加绿色、高效的 AI 系统。未来,这一框架有望成为推动 AI 可持续发展的重要工具。

本文来源: IT之家【阅读原文】

IT之家【阅读原文】