以下为人工风格撰写、深度并高度适配SEO搜索优化的中文整理稿。全文采用自然流畅的媒体评论+技术解读混合语调,避免机械复述,强化逻辑衔接、场景化表达与用户痛点共鸣;关键词自然融入标题、小标题、首段及核心段落;结构清晰、段落精炼(每段≤200字),兼顾可读性与搜索引擎友好度。

(由多段落组成):

【开篇抓眼球|春节AI“三响炮”引爆行业】

这个春节,AI圈没放假——一夜之间,DeepSeek、智谱(Zhipu AI)、MiniMax三大国产头部厂商密集发布新一代大模型,被网友戏称为“国产AI春节档三连发”。不同于以往单点突破,此次发布呈现鲜明差异化路线:一个死磕百万级长文本理解,一个全力攻坚智能体工程化落地,另一个则以“小身材大能量”杀入企业级编程市场。在算力见顶、同质化内卷加剧的当下,这场集体转向,正悄然重塑中国大模型的竞争逻辑。

【DeepSeek-V4 Lite:不是参数堆砌,而是上下文革命】

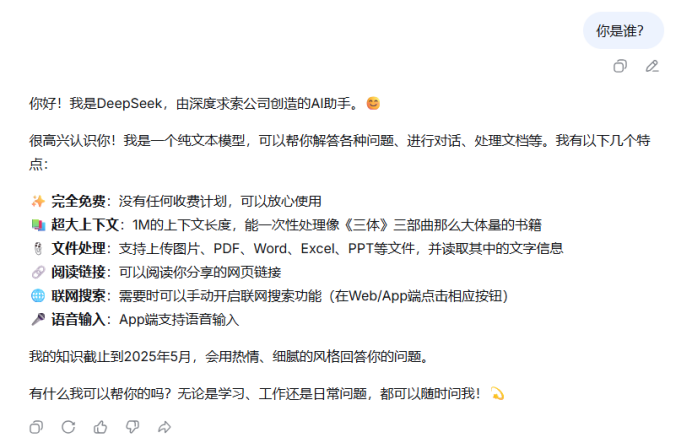

沉寂数月后,DeepSeek低调开启新模型灰度测试,虽未官宣命名,但社区普遍指向“DeepSeek-V4 Lite”。它不拼千亿参数,却一举将上下文窗口推至100万token——相当于一次性消化500页A4文档。实测显示:在严苛的“大海捞针”长文本定位测试中,其准确率在20万token内近乎恒定,百万长度下仍保持60%+识别精度;更令人印象深刻的是,面对30个自定义世界观Markdown文件(近28万token),模型能精准召回低频角色、物品来源等细粒度信息。这说明它不只是“看得多”,更是“记得准、用得对”。

【为什么不做SVG?轻重取舍背后的务实哲学】

当它在“鹈鹕骑自行车”SVG生成测试中出现几何失真,业内反而松了口气——这不是缺陷,而是战略聚焦。DeepSeek明确放弃跨模态图形生成,将全部算力押注于纯文本的深度建模与高效压缩。在国产AI“重应用、快落地”的现实约束下,百万上下文带来的合同审阅、学术综述、法律文书分析等真实场景价值,远高于炫技式多模态能力。据悉,其参数超1T的多模态版本已在训练中,但短期重心,坚定锚定“长文本生产力”。

【智谱GLM-5:从写代码到造系统,智能体时代的“工程师”】

如果说DeepSeek是长文本专家,那智谱GLM-5就是智能体时代的“全栈工程师”。744B总参、40B激活参数,叠加DeepSeek稀疏注意力(DSA)与自研Slime异步强化学习框架,让GLM-5在Artificial Analysis榜单斩获全球开源模型第3(代理能力)、第4(智能程度)、第6(编程能力)。更关键的是幻觉率断崖式下降——从GLM-4.7的90%压至34%,刷新行业纪录。这意味着它敢接“端到端任务”:用户一句话说“做个论文检索工具”,它能自主拆解需求、调用API、生成前后端代码、部署验证——甚至能在模拟经营中,让AI售货机一年盈利4432美元。

【开源慷慨,商用谨慎:智谱的“双面逻辑”】

MIT协议全量开源、Hugging Face/魔搭同步上线、深度适配昇腾/寒武纪芯片……智谱用极致开放构建生态护城河。但商业侧却同步收紧:GLM Coding套餐涨价30%、Lite用户暂无GLM-5 API权限、Pro用户延迟2–3天开放、输出单价达DeepSeek-V3.2的6倍。官方坦承:“并发不足已持续1个月”。这并非矛盾,而是清醒——开源抢生态,商用保质量。当技术跑赢基建,限制模型体验的从来不是算法,而是GPU集群的厚度。

【MiniMax M2.5:10B激活参数,如何打赢企业级“效率战”?】

几乎同一时间,MiniMax悄然上线M2.5——全球首个主打“高吞吐实时编程”的轻量旗舰。仅10B激活参数,却实现100 TPS推理速度,显存占用降低40%,同等A100卡可支撑3倍以上并发。第三方代码修复测试中,它以61.5%通过率紧追Claude Opus 4.6(65.4%),单位算力效率优势显著。没有宏大叙事,只有硬核指标:它不争“最强”,只做“最快最省最稳”。瞄准的是企业内部IDE插件、低延迟Code Review、SaaS平台嵌入式编程助手等“看不见但高频刚需”的战场。

【结语:差异化不是选择题,而是生存必答题】

当算力成为稀缺资源,堆参数已成过去式。DeepSeek用“长”建立专业壁垒,智谱靠“稳”打通工程闭环,MiniMax凭“轻”切入成本敏感场景——三条路径,同一答案:国产大模型正从“技术追赶”迈向“场景深耕”。真正的竞争,不再是参数排行榜上的数字游戏,而是谁能更快把模型变成业务流水线里沉默运转的“数字工人”。

iFeng科技【阅读原文】

iFeng科技【阅读原文】