以下是根据原始进行人工风格整理后的文章,旨在提升SEO优化效果,同时保持原意与技术深度。文章结构清晰、关键词自然分布,适合搜索引擎抓取和用户阅读。

## (由多段落组成)

人工智能新贵发布首个研究成果,估值高达120亿美元

2025年9月11日,备受瞩目的AI初创公司Thinking Machines正式发布了其成立以来的首篇研究博客,主题聚焦于解决大语言模型(LLM)推理过程中的非确定性问题。尽管该公司尚未推出任何具体产品,但其估值已高达120亿美元,成为AI领域最引人注目的“独角兽”。

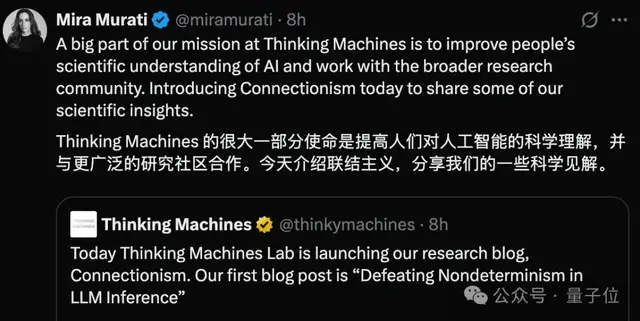

该研究由公司创始人兼前OpenAI首席技术官Mira Murati亲自发布,团队成员翁荔等也纷纷在社交平台转发支持,显示出这一成果在公司内部的重要地位。

LLM推理为何难以复现?根源在于批次不变性

研究核心围绕“Defeating Nondeterminism in LLM Inference”展开,探讨了当前大模型在推理过程中结果难以复现的问题。即使用户在相同条件下多次输入相同提示,输出结果也可能出现差异,即便将采样温度设置为0,也无法完全消除这种不确定性。

过去,业界普遍认为这是由于浮点数运算的非结合性所致,即在并行计算中,运算顺序的不同可能导致最终结果不同。然而,研究团队通过深入实验发现,真正导致推理结果不稳定的关键因素是批次不变性缺失。

批次不变性为何如此重要?

在实际应用中,服务器会根据负载动态调整推理批次的大小。而当前主流推理框架在处理不同批次时,会改变诸如矩阵乘法、RMSNorm等关键操作的计算顺序,从而引发微小偏差。这些偏差在Transformer模型中经过多层叠加后被放大,最终导致输出结果的不一致。

为解决这一问题,研究人员提出了一系列优化策略,包括:

– 固定RMSNorm归约顺序:确保每个批次元素在单个核心中完成归约操作;

– 矩阵乘法的批处理优化:采用2D块划分方式,避免Split-K等策略带来的不确定性;

– 注意力机制的稳定处理:统一KV缓存存储布局,保障序列维度归约顺序不变。

实验验证与性能表现

为验证上述方法的有效性,团队使用Qwen-3-235B-A22B-Instruct-2507模型进行了三类实验:推理确定性验证、性能测试以及在线策略强化学习应用验证。

结果显示,在未使用批次不变性内核时,1000次推理中出现了80种不同结果,且从第103个token开始出现明显分化。而启用优化策略后,所有推理结果完全一致,实现了确定性输出。

虽然性能上略有下降(约20%),但在实际部署中仍处于可接受范围,具备实际应用价值。

在线策略强化学习稳定性显著提升

研究还发现,推理过程中的数值不一致会影响强化学习的训练过程,导致在线策略RL退化为离线策略,需引入重要性加权等校正手段。而通过确定性推理,KL散度始终维持在0,无需额外校正即可实现稳定训练。

Thinking Machines:汇聚顶尖AI人才的创业团队

除了技术成果,Thinking Machines的团队背景也堪称豪华。公司核心成员多来自OpenAI,包括:

– Mira Murati:前OpenAI CTO,主导GPT-3、GPT-4开发;

– John Schulman:PPO算法发明人,强化学习领域权威;

– Barret Zoph:前OpenAI副总裁,负责ChatGPT后训练;

– Andrew Tulloch:OpenAI GPT-o系列核心开发者;

– Alec Radford:GPT初代论文作者;

– 翁荔:前OpenAI安全团队负责人,北大校友;

– 陈丹琦(据传加入):清华姚班出身,NLP领域专家。

此外,公司还吸引了英伟达、a16z、CISCO等科技巨头的投资,种子轮融资达20亿美元,刷新AI初创公司融资纪录。

Connection Machine:连接主义的现代演绎

翁荔在推文中透露,Thinking Machines的首款产品名为Connection Machine,向“连接主义”致敬。连接主义起源于上世纪60年代,以神经网络为实现形式,如今的深度学习正是其延续。

有网友调侃:“先把Logo发出来吧!”可见公众对这家公司未来动向的高度关注。

##

本文来源: 量子位【阅读原文】

量子位【阅读原文】