整理后文章(、SEO优化版):

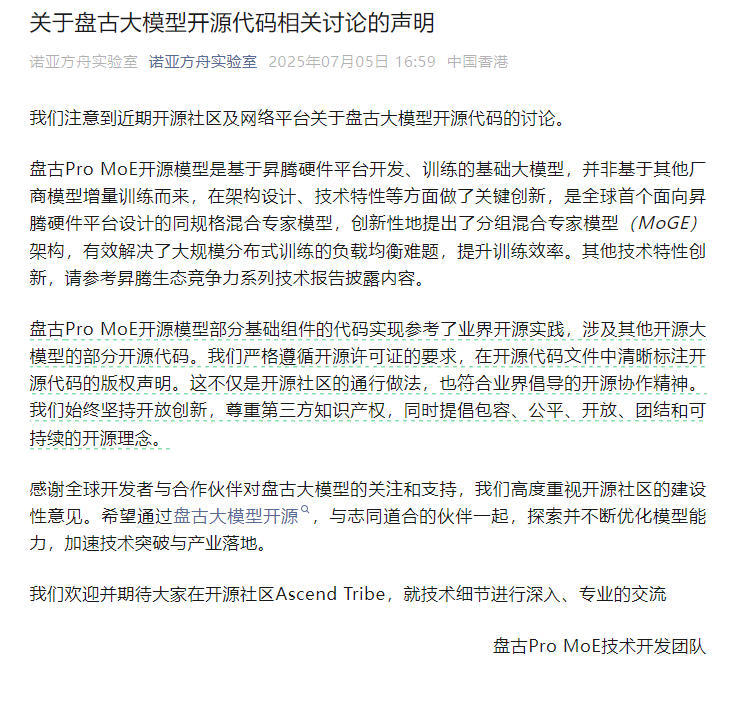

近日,围绕开源社区及部分网络平台上对华为盘古大模型代码来源的讨论持续升温。对此,华为盘古Pro MoE技术团队于7月7日正式发布官方回应声明,针对相关争议进行了详细说明。

在声明中,华为方面明确表示,盘古Pro MoE是一款基于自家昇腾(Ascend)AI硬件平台开发与训练的基础性大规模人工智能模型,并非在其他厂商已有模型基础上进行增量训练的结果。该模型在整体架构设计和技术实现上,具备多项自主创新成果。

值得一提的是,华为特别介绍了其提出的“分组混合专家模型”(MoGE)架构。据悉,这是全球首个专为昇腾平台打造的同类混合专家模型结构。MoGE的核心优势在于有效应对大规模分布式训练过程中常见的负载不均衡问题,从而大幅提升模型训练的整体效率和稳定性。更多技术细节可通过昇腾生态竞争力系列技术报告进一步了解。

关于外界关注的部分代码相似性问题,华为也未回避。官方承认,在构建盘古Pro MoE的过程中,确实参考了业界已有的开源实践,并使用了一些来自其他开源大模型的基础组件代码。但开发团队强调,所有引用行为均严格遵守开源许可证的相关规定,并在相应代码文件中保留了原始版权声明,符合开源社区普遍认可的合作原则。

最后,华为重申其一贯坚持的开放创新理念,强调尊重并保护第三方知识产权。同时,官方鼓励开发者和合作伙伴积极参与到Ascend Tribe开源社区的技术交流中,深入探讨模型优化方向,推动AI技术的实际应用落地。

盘古大模型, 华为昇腾, MoGE架构, 开源社区, 代码合规性

本文来源: iFeng科技【阅读原文】

iFeng科技【阅读原文】 © 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...