整理后文章

一款能够同时完成分割、识别和解说任务的全能模型来了!这款名为PAM(Perceive Anything Model)的模型,由香港中文大学MMLab、香港理工大学、北京大学等机构联合开发并开源。它不仅支持图像和视频处理,还能同时输出文本和Mask结果,真正实现了一次交互解决多种需求。

PAM在继承了SAM2强大分割能力的基础上,进一步扩展了语义信息输出功能。为了训练这一高效模型,研究团队构建了一个包含150万张图像区域和60万段视频区域标注的超大规模高质量数据集。实验结果显示,PAM仅用3B参数规模,便在多个图像和视频理解基准测试中刷新或逼近SOTA,同时具备更优的推理效率和显存占用表现。

PAM:精准定位与语义解析

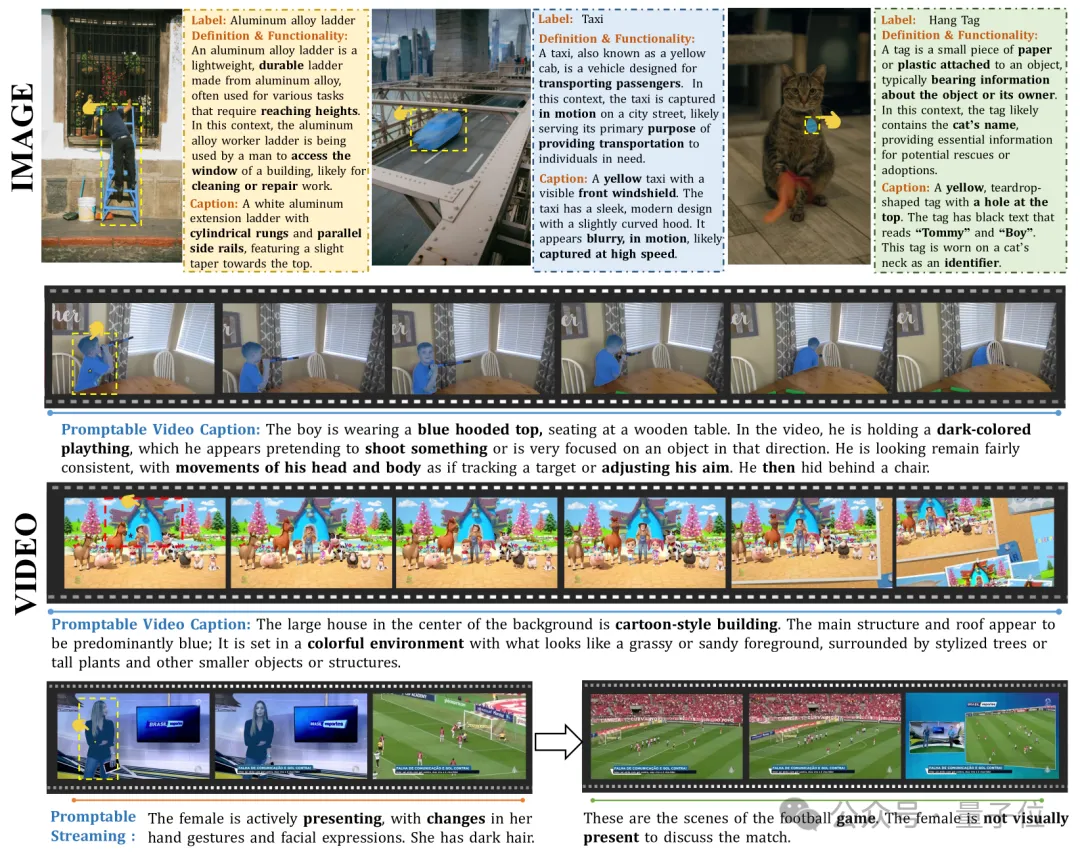

PAM不仅保留了SAM2的“分割一切”和“追踪一切”能力,还新增了丰富的语义信息输出功能。对于图像任务,用户只需点击一次即可获取目标区域的类别、解释和精细描述;而对于视频任务,PAM支持整段描述和流式描述,能够实时追踪目标并动态生成叙述。

工作原理:框架设计与数据支持

PAM通过引入Semantic Perceiver模块,将SAM2的分割骨架与LLM相结合,实现了视觉特征到多模态token的有效转换。其核心架构包括SAM2分割骨架、Semantic Perceiver和LLM并行解码器,能够在保证轻量高效的同时,输出分割Mask和语义信息。

为支撑PAM的训练,团队构建了一个多层次、高密度的图像与视频语义标注数据集。图像数据采用SoM方法进行目标区域精确定位,并结合闭源VLM生成类别、解释和描述三类语义信息。视频数据则通过Storyboard驱动式理解,提取关键帧并生成时间感知强的事件描述。此外,PAM还在长视频处理中引入递归机制,确保字幕连贯性和上下文一致性。

实验结果:规模小性能强

实验表明,PAM-3B在多个基准测试中表现出色。例如,在PACO基准测试中,PAM-3B超越先前最佳模型3.2%以上;在LVIS基准测试中,语义IoU指标超过当前SOTA模型DAM-8B。此外,PAM-3B在Total-Text和COCO-Text等任务上也展现了显著优势。

相比同参数量的DAM-3B模型,PAM-3B在推理速度和显存占用方面更具优势。更重要的是,PAM首次实现了区域级流式视频字幕能力,能够持续描述物体行为并在连续事件中保持高度语义一致性。

相关链接

– 论文地址:[https://arxiv.org/abs/2506.05302](https://arxiv.org/abs/2506.05302)

– 项目主页:[https://perceive-anything.github.io/](https://perceive-anything.github.io/)

– GitHub Repo:[https://github.com/Perceive-Anything/PAM](https://github.com/Perceive-Anything/PAM)

– 模型检查点:[https://huggingface.co/Perceive-Anything/PAM-3B](https://huggingface.co/Perceive-Anything/PAM-3B)

– 数据集:[https://huggingface.co/datasets/Perceive-Anything/PAM-data](https://huggingface.co/datasets/Perceive-Anything/PAM-data)

量子位【阅读原文】

量子位【阅读原文】