(由多段落组成):

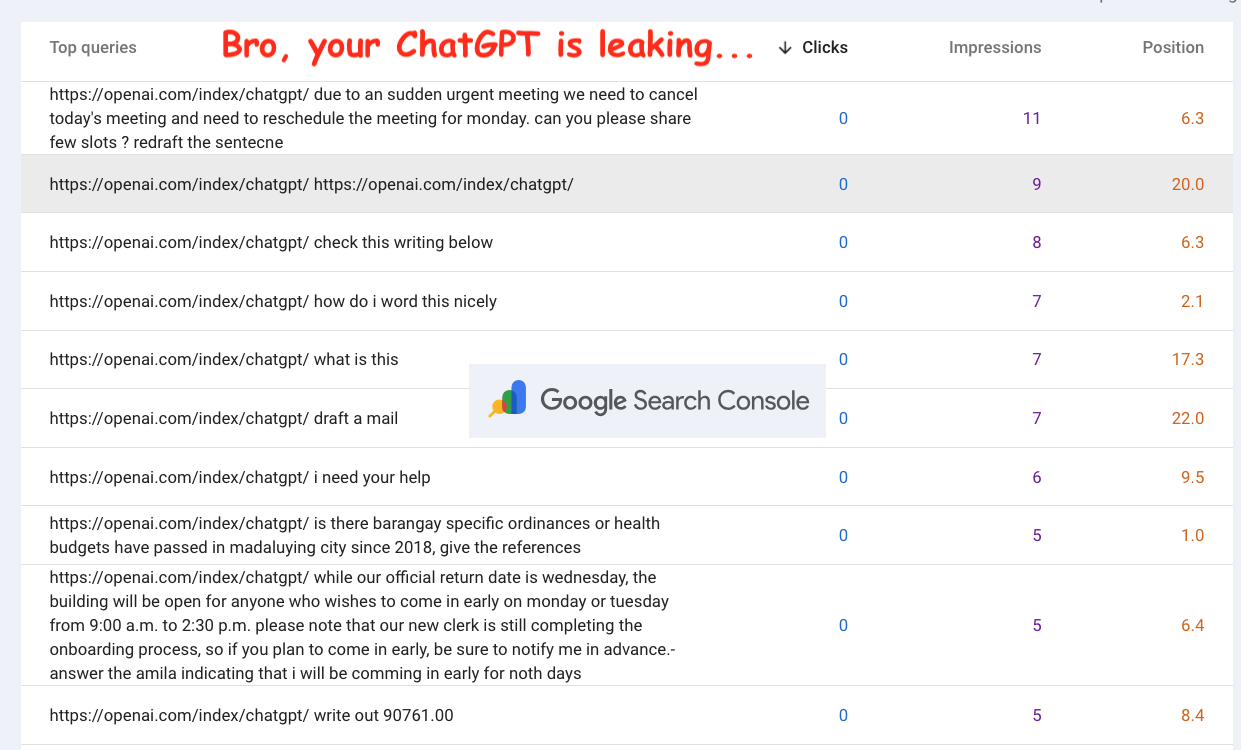

近日,知名科技媒体 Ars Technica 报道了一起涉及 ChatGPT 用户隐私泄露的严重事件。据披露,自2023年9月以来,部分用户的私密对话意外出现在谷歌搜索控制台(Google Search Console,简称 GSC)中。这一现象引发了业界对人工智能平台数据安全与用户隐私保护机制的广泛担忧。GSC 是谷歌为网站管理员提供的免费分析工具,通常用于监测网站在搜索结果中的表现,如关键词排名、点击率等。然而,近期一些管理员发现,系统中竟出现了长达300字符以上的“异常查询”,竟是用户向 ChatGPT 提出的情感倾诉或商业咨询的完整聊天记录。

这些对话本应属于高度敏感的私人信息,用户在使用 ChatGPT 时普遍认为其交流受到加密和隐私政策的保护。但此次事件显示,某些用户的提问被自动转化为谷歌搜索请求,并暴露在 GSC 数据中。调查由数字营销咨询公司 Quantable 的创始人 Jason Packer 与 SEO 专家 Slobodan Manić 共同展开。他们指出,问题根源可能出在一个存在技术缺陷的 OpenAI 页面上——该页面会将固定 URL(https://openai.com/index/chatgpt/)拼接到用户输入前,并触发对谷歌的强制搜索行为。由于只有通过直接网页抓取而非标准 API 接口调用才会在 GSC 中留下此类痕迹,因此研究者推测,这可能是 OpenAI 在未经明确告知的情况下,利用真实用户提示进行搜索引擎数据采集的首个实证。

面对质疑,OpenAI 官方回应称已“修复了一个影响少量搜索路由的技术故障”,并强调问题已被解决。但值得注意的是,该公司并未正面回应是否曾主动抓取谷歌搜索数据,也未公布受影响用户的具体数量及时间范围,导致公众对其数据处理透明度产生质疑。与此同时,谷歌方面则保持沉默,拒绝就此事发表任何评论。专家指出,这种模糊态度使得外界难以判断 OpenAI 是否仍在持续收集类似数据,也无法确认当前的安全隐患是否已被彻底根除。

与以往因用户主动分享链接导致的信息外泄不同,本次事件的最大风险在于其“被动性”——用户无需任何操作,其私密对话便可能被系统自动上传并暴露于第三方监控平台。更令人不安的是,一旦这些聊天记录进入 GSC 系统,目前尚无有效手段将其完全清除,意味着敏感信息可能长期留存于网络日志中。尽管 OpenAI 声称仅“少量”查询受到影响,但由于缺乏独立审计和公开数据支持,实际波及范围仍成谜。

此次事件不仅暴露出 AI 服务背后潜在的数据流转风险,也再次敲响了用户隐私保护的警钟。随着生成式人工智能的普及,如何确保用户输入不被滥用、转录或间接用于训练以外的目的,已成为行业亟待解决的核心议题。未来,平台方需加强技术审查机制,提升响应透明度,并建立更严格的权限控制体系,以重建用户信任。同时,监管机构也可能需要介入,推动制定更明确的 AI 数据使用规范,防止类似隐私泄露事件重演。

本文来源: IT之家【阅读原文】

IT之家【阅读原文】