第一段

在当今AI技术飞速发展的时代,图像生成、视频创作和照片精修等任务通常需要依赖不同的模型来完成。然而,这种分散的方式无疑增加了操作的复杂性和时间成本。有没有一种“全能型”的解决方案,只需通过简单的自然语言描述,就能自动完成从创意构思到高质量视觉作品输出的全过程?现在,由香港科技大学(广州)与字节跳动联合研发的全新开源框架——ComfyMind,成功实现了这一目标。

第二段

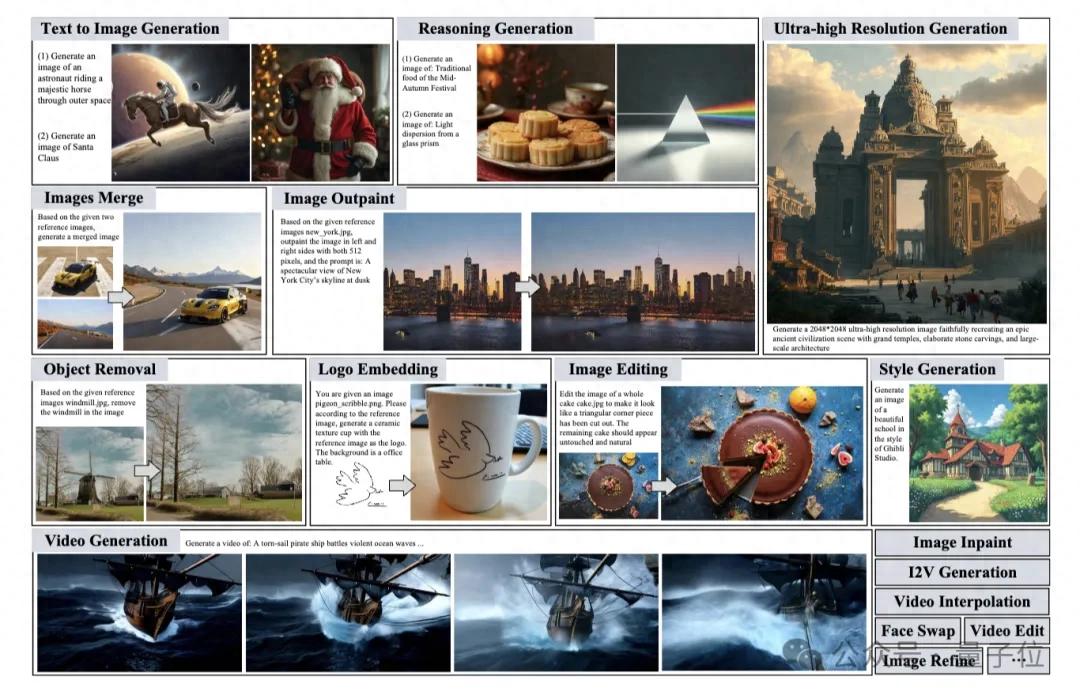

ComfyMind是一款通用视觉生成框架,其核心理念是通过一套系统化的方法,统一处理文本到图像、图像到视频等各种主流视觉生成任务。在多个行业基准测试中,ComfyMind的表现全面超越了现有的开源方法,并且其性能已经达到了与闭源GPT-4o-Image相当的水平。

第三段

无论是模拟棱镜散射出精确的彩虹光谱,还是为蛋糕切下一块,甚至将一个Logo无缝融入产品设计中,ComfyMind都能轻松应对。以下是几个具体的应用示例:

– 结合光学知识生成玻璃棱镜的光散射图像;

– 在一张蛋糕图片上实现精准切角;

– 将Logo嵌入杯子的设计中;

– 生成一段8秒长的海边篝火燃烧视频。

第四段

尽管目前的视觉生成模型取得了显著进步,但能够“一网打尽”所有任务的开源框架仍然稀缺,难以满足实际生产需求。相比之下,闭源的GPT-Image-1虽然效果出色,但社区无法自由扩展或优化。为了解决这些问题,ComfyUI的节点式设计提供了“可视化、模块化”的基础,理论上任何任务都可以通过组合节点完成。然而,当工作流涉及多模态或多阶段时,手工搭建不仅耗时费力,还对专业知识有较高要求。

第五段

针对这些痛点,ComfyMind团队提出了“原子工作流”的概念,以自然语言作为接口,结合树状规划和局部反馈执行机制,将复杂的视觉创作转化为分层决策问题。这种方式不仅保持了系统的灵活性,还显著提升了稳健性和扩展性。

第六段

ComfyMind的整体架构基于“ComfyUI × 多代理协同”的设计理念。其中,规划代理负责自顶向下拆解任务,执行代理则将每一步映射成JSON工作流并通过ComfyUI进行具体生成,而评估代理会在生成流程结束后使用VLM判断生成质量,并将诊断信息反馈给上一层级。

第七段

为了进一步提升系统的稳定性和效率,ComfyMind引入了语义工作流接口(SWI)。该接口将社区验证的模板封装为“原子工作流”,并以自然语言标注其功能及参数。这使得规划代理能够在纯语义空间中像调用高阶函数一样组合模块,避免了JSON语法错误带来的结构性故障。

第八段

在性能评估方面,ComfyMind在三大基准测试中表现出色:

– 在ComfyBench自动工作流构建测试中,ComfyMind实现了全难度任务100%的通过率,并在问题解决率上较其他方法大幅提升;

– 在GenEval文生图测试中,ComfyMind获得了0.90的总分,领先于开源基线SD3和Janus-Pro-7B;

– 在Reason-Edit图像编辑测试中,ComfyMind以0.906的GPT-score接近GPT-Image-1(0.929),并在复杂编辑指令的完成度上表现优异。

第九段

综上所述,ComfyMind是一款革命性的视觉生成框架,它将视觉创建过程模块化、语义结构化,并通过树状规划与局部反馈执行相结合,大幅提升了系统的性能和稳定性。相关论文、在线Demo、代码及项目主页均已公开发布,感兴趣的用户可以深入体验和探索。

量子位【阅读原文】

量子位【阅读原文】