当然可以!以下是对你提供的文章进行人工风格的整理,并优化了SEO结构。文章更符合搜索引擎收录和排名的要求,同时保留了原文的核心信息与技术亮点。

## (由多段落组成)

全球首个“生命视觉”大模型诞生:AI一眼识别95万物种

近日,一项突破性的研究成果引发广泛关注——来自俄亥俄州立大学的研究团队成功训练出新一代生物视觉模型 BioCLIP 2,该模型能够在无监督条件下精准识别高达 95.2万个物种,并且具备理解生态关系、个体差异的能力,堪称“AI界的生物学专家”。

这项成果不仅刷新了当前物种识别领域的准确率记录,还在多个非物种相关任务中表现出色,如栖息地判断、植物疾病检测等,展现出其强大的泛化能力。

规模+结构化监督=生物视觉涌现能力

BioCLIP 2 的核心理念借鉴了大语言模型中的“涌现能力”理论:当模型规模足够大,并配合结构化的监督信号时,AI会自主学习到超出原始目标的知识。

研究团队将经典的 CLIP 架构引入生物领域,通过引入包括“界-门-纲-目-科-属-种”的分类体系、学名与俗名等多种文本标签作为监督信号,构建了一个前所未有的大规模生物图像语义对齐系统。

他们提出一个关键问题:如果我们把数据量从千万级提升至亿级,是否能让AI在没有明确标注的情况下“看懂”更多生物学知识?

答案是肯定的。

数据驱动下的“生命之树”视觉模型

为实现这一目标,研究团队整合了全球四大权威数据库——GBIF、EOL、BIOSCAN-5M 和 FathomNet,构建了目前最大最全面的生命图像数据集 TreeOfLife-200M,包含 2.14亿张图像,覆盖 95.2万种生物分类,涵盖标本图、野外拍摄、水下影像等多种类型。

在模型架构方面,团队也进行了升级,将原来的 ViT-B 模型扩展至更大的 ViT-L 结构,从而为模型提供更强的学习能力与表达空间。

BioCLIP 2性能表现亮眼

在多项测试中,BioCLIP 2 表现出色:

– 在零样本物种识别任务中,平均准确率达到 55.6%,比第二名 SigLIP 高出 16.1个百分点;

– 少样本识别任务中,远超主流视觉模型 DINOv2;

– 同时,在栖息地识别、生物属性分析、新物种发现及植物病害检测等多个非物种任务中也实现了显著领先。

值得注意的是,这些任务在训练过程中并未给予任何直接监督信号,但模型依然能够高效完成,这表明其已具备一定的“生物学理解力”。

生物特征空间的两大“涌现特性”

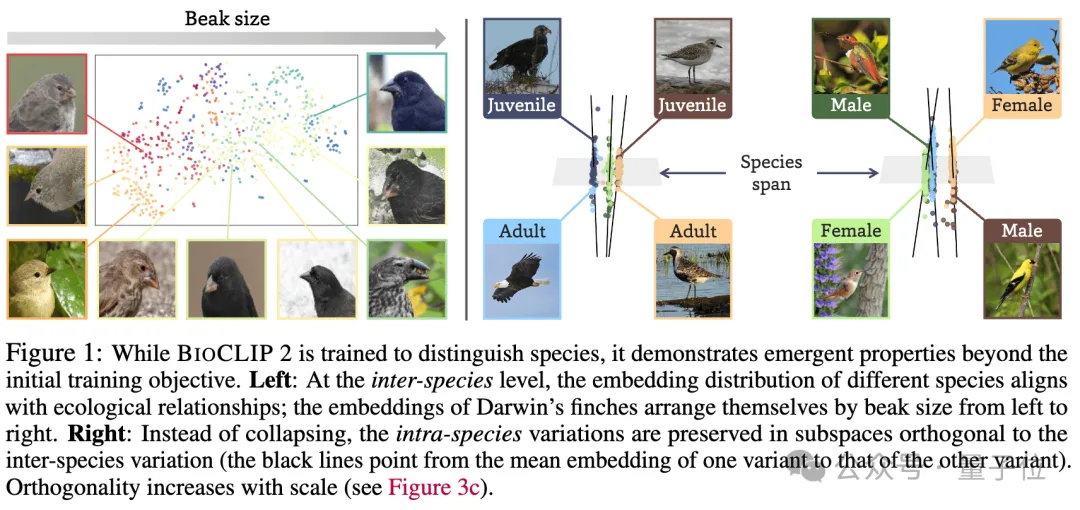

深入分析后,研究人员发现了 BioCLIP 2 的两个重要“涌现特性”:

1. 物种间生态对齐

– 相似生态环境或功能特性的物种在特征空间中自然聚类,例如淡水鱼与咸水鱼之间的界限随训练数据增加而愈发清晰。

– 这一现象源于层级标签引导模型将生态相似物种映射到相近的文本原型上,从而实现视觉与功能特征的统一。

2. 物种内差异分离

– 同一物种内的性别、年龄等个体差异被保留在与物种区分正交的子空间中,且随着训练数据增长,这种正交性不断增强。

– 论文指出,这种分布不会干扰物种分类任务,使得AI在识别物种的同时也能捕捉个体细节。

实验结果显示,从100万到2.14亿张图像的四阶段训练过程中,所有非物种任务性能持续提升,验证了训练规模扩大的巨大潜力。

总结:专业领域也能复现大模型“涌现效应”

BioCLIP 2 的成功证明:只要监督方式得当、数据规模足够庞大,即使在高度专业的生物视觉领域,也能复现类似大语言模型的“涌现能力”。它不仅提升了物种识别的准确率,还让AI真正“理解”了生物世界的复杂性。

未来,这一模型有望广泛应用于生态监测、自然保护、农业病害预警等多个领域,推动人工智能与生命科学的深度融合。

##

本文来源: 量子位【阅读原文】

量子位【阅读原文】