随着人工智能技术的飞速发展,医疗领域的应用也逐渐成为关注焦点。近日,OpenAI 推出了一款专为医疗大模型设计的测试评估集——HealthBench,并将其开源。这一举措旨在更全面、准确地衡量 AI 系统在医疗健康领域的能力。

HealthBench 的核心特点在于其由全球范围内的专业医生团队精心打造。具体来说,来自 60 个国家和地区的 262 名医生共同参与了测试集的设计工作,生成了 5000 段高质量的核心测试对话。这些对话不仅涵盖了复杂的医疗场景,还确保了测试集的真实性和多样性。与传统狭窄基准不同,HealthBench 提供了更加开放和多维度的评估方式,通过 48562 个独特的评分标准进行综合考量。这些标准覆盖了多个健康背景(如紧急情况、全球健康)以及行为维度(如准确性、沟通能力等),为医疗 AI 的性能提供了更为全面的参考依据。

值得一提的是,HealthBench 引入了多轮对话测试模式,而非简单的答题或选择题形式。这种创新方式能够更真实地模拟实际医疗场景中的交互过程,从而更好地评估模型的实际应用能力。根据最新测试数据显示,大型语言模型在医疗保健领域的表现显著提升。例如,从 GPT-3.5 Turbo 到 GPT-4o,再到 GPT-o3,整体性能分别提升了 16%、32% 和 60%。特别引人注目的是小型模型的进步,GPT-4.1 nano 不仅在性能上超越了 GPT-4o,还实现了成本降低 25 倍的突破。

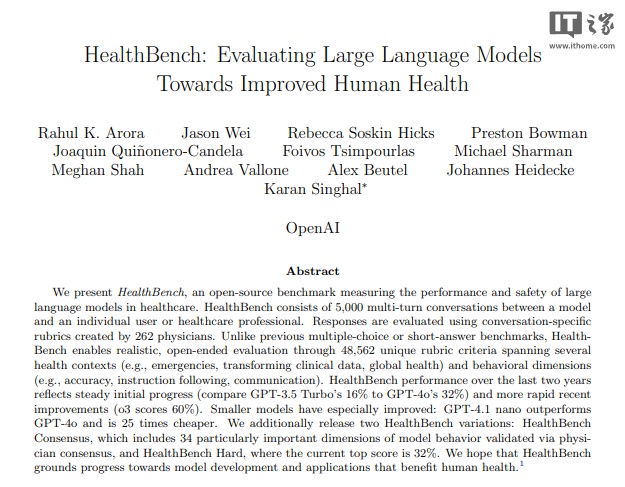

相关研究成果已发布于论文《HealthBench: Evaluating Large Language Models Towards Improved Human Health》中,进一步展示了 OpenAI 在推动医疗 AI 发展方面的努力与成果。此外,文章内含对外跳转链接(包括但不限于超链接、二维码等形式),仅供读者获取更多信息,结果仅供参考。

本文来源: IT之家【阅读原文】

IT之家【阅读原文】